O que é robots.txt?

robots.txt é um arquivo que controla o rastreamento de rastreadores de mecanismos de pesquisa. Ao impedir que os rastreadores acessem conteúdo desnecessário com o robots.txt, você pode reduzir a carga no servidor e melhorar a eficiência do rastreamento. Use noindex em vez de robots.txt para evitar que ele apareça nos resultados da pesquisa.

O robots.txt foi inventado por Martijn Koster em 1994. Além de bloquear rastreadores específicos, você também pode especificar a localização do seu arquivo xml de mapa do site para os mecanismos de pesquisa.

Normalmente, um arquivo chamado robots.txt é criado e carregado por FTP diretamente no diretório superior do site, incluindo a descrição que controla o rastreador.

Em julho de 2019, o Google anunciou que estava embarcando em uma iniciativa para tornar o protocolo robots.txt um padrão da Internet.

Formalizando a Especificação do Protocolo de Exclusão de Robôs

Quando o robots.txt é necessário?

Se você deseja exibir todas as páginas nos resultados da pesquisa, não precisa defini-lo.

Controle o rastreamento com robots.txt se seu site for grande e os rastreadores tiverem um impacto significativo no desempenho do servidor. Além disso, é uma boa ideia configurar um sitemap XML e um feed rss para eficiência de rastreamento .

O robots.txt é usado apenas para controlar o rastreamento. Não pode ser usado com a finalidade de não ser exibido nos resultados da pesquisa. Nesse caso , use noindex ou autenticação básica .

Páginas para restringir o rastreamento

Por exemplo:

Página de login do CMS se estiver usando um CMS

Não faz sentido permitir que os mecanismos de pesquisa o rastreiem, para que você possa bloqueá-lo.

Conteúdo para membros

Em geral, use autenticação básica ou algo semelhante para limitar o próprio acesso de terceiros.

Processo de checkout no carrinho de compras

No caso de sites EC, geralmente clicar no botão de compra na página do produto fará a transição para a tela de pagamento. (Acho que a URL dessa tela de pagamento é diferente para cada visitante e é gerada dinamicamente.)

URLs gerados dinamicamente, como páginas de carrinho, são páginas inúteis para usuários de pesquisa.

Quando a escala do site aumenta, a eficiência da patrulha do rastreador diminui e a carga no servidor pode aumentar.

Os rastreadores não rastreiam todas as páginas do seu site todos os dias, mas atribuem tamanhos de download para rastreamento com base em fatores como o tamanho do seu site e a frequência com que você atualiza. Como a carga no servidor aumenta devido ao rastreamento do rastreador para páginas desnecessárias, é melhor usar o robots.txt nesses casos.

O Google não é a única causa do aumento de carga, portanto, também podemos controlar rastreadores e arquivadores estrangeiros. (como ia_archiver.)

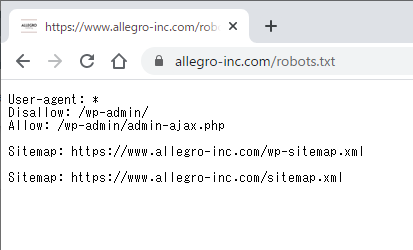

Como escrever robots.txt

User-agent: *

Disallow: /wp-admin/

Sitemap: http://www.example.com/sitemap.xml

No caso do WordPress, acho que geralmente é definido como acima.

Esta é uma descrição para bloquear o acesso a /wp-admin/ para todos os rastreadores.

Agente de usuário

User-agent é lido como user-agent.

Especifique o rastreador do mecanismo de pesquisa de destino aqui.

Você pode verificar o agente do usuário de cada rastreador do mecanismo de pesquisa na página a seguir.

http://www.robotstxt.org/db.html

Proibir

Não permitir rastreamento de blocos para o URL especificado.

Bloqueie o rastreamento de todo o site com uma barra “/” antes de o site ser publicado.

Se você quiser bloquear tudo em um diretório específico, escreva como “/sample/”. (É uma descrição que bloqueia tudo no diretório /sample/.)

Você também pode especificar uma unidade de página específica como “/privacy.php”.

Existem também outros casos em que a descrição “Permitir” é usada. Escreva isso se quiser apenas permitir o rastreamento de URLs de diretórios filho específicos dentro de um diretório bloqueado por Disallow.

Mapa do site:

Diga ao rastreador onde encontrar seu mapa do site XML.

Em relação ao Google, não é necessário se você registrou um sitemap XML no Search Console, mas é melhor descrevê-lo porque existem outros mecanismos de pesquisa.

comente

Use # para comentar.

# 2021/4/7 Adicionado

User-agent: *

Disallow: /wp-admin/

Sitemap: http://www.example.com/sitemap.xml

Diversos: noindex, nofollow, crawl-delay

Embora não seja um método oficial, foi possível descrever ” noindex “, “nofollow” e “crawl-delay” em robots.txt para informar alguns rastreadores do processo, mas após novembro de 2019 Não suportado pelo Googlebot.

Consulte ” Criando um arquivo robots.txt ” para obter uma descrição mais detalhada do método .

Formato robots.txt, local de upload

Salve-o como um arquivo chamado robots.txt e carregue-o no topo do diretório do site (primeiro nível).

Mesmo os subdomínios parecem ser reconhecidos se carregados no diretório superior.

No entanto, parece que não é detectado, mesmo que seja carregado em um subdiretório.

formato de arquivo

O formato do arquivo Robots.txt é o seguinte.

O formato de arquivo esperado é texto simples codificado em UTF-8. Este arquivo consiste em registros (linhas) separados por CR, CR/LF ou LF.

No caso do Google, parece não haver problema, desde que seja escrito corretamente em páginas HTML diferentes do formato txt.

Limite de tamanho de arquivo

Há um limite de tamanho de 500 KB e qualquer conteúdo acima desse tamanho será ignorado.

Especificação do robots.txt – formato de arquivo

Por fim, verifique se há algum erro no robots.txt

Após o upload, certifique-se de verificar se há erros com o testador robots.txt no Search Console.

Selecione a propriedade apropriada e quando o “testador robots.txt” aparecer, insira a URL específica e clique no botão “Testar”.

Notas sobre robots.txt

Existem algumas ressalvas ao usar o robots.txt.

Até 10 redirecionamentos consecutivos podem ser processados

Outros redirecionamentos parecem ser tratados como erros no Search Console.

O que fazer se for uma resposta 5XX

Como ação temporária, o Google reconhece que o acesso ao site é totalmente negado.

Se o robots.txt não estiver acessível com uma resposta 5xx por 30 dias, o arquivo robots.txt armazenado em cache anterior será usado. Se não for armazenado em cache, será tratado como se não houvesse limite de rastreamento.

O que fazer com respostas 500/503

Se você continuar retornando um código de status HTTP 500/503 após um determinado período de tempo ao acessar seu arquivo robots.txt, seu site não aparecerá nos resultados de pesquisa, mesmo que o Googlebot consiga acessar outras partes de seu site. parece ter sido excluído . A mesma coisa parece acontecer no caso de tempos limite de rede de longo prazo.

Um arquivo robots.txt que retorna um código de status HTTP 500/503 por um longo período de tempo removerá seu site dos resultados de pesquisa, mesmo que o restante do site esteja acessível ao Googlebot. O mesmo vale para tempos limite de rede.Comentários de Gary Illyes

Tratar como erro do servidor

Solicitações com falha ou dados incompletos são tratados como erros do servidor.

Aplicação de robots.txt

Robots.txt parece ser seguido pelos principais mecanismos de pesquisa, como o Google, conforme escrito, mas alguns rastreadores parecem ignorá-lo. Para bloqueá-lo completamente, você pode configurar a autenticação básica.

Páginas rastreadas de links externos não podem ser bloqueadas

Se um rastreador seguir links de referência de outros sites para sua página bloqueada por robots.txt, ele poderá ser indexado. É uma boa ideia bloqueá-lo usando autenticação básica ou uma meta tag noindex.

Por outro lado, se a página que você está bloqueando for uma página popular e importante com muitos backlinks, o Google pode ignorar esses backlinks e não julgar corretamente a importância do site. Nesses casos, sua classificação no Google pode cair.

Horário de atendimento do Google SEO em inglês a partir de 11 de dezembro de 2020

URLs usados como parte dos componentes da página não são bloqueados

Se houver uma página chamada A que permite o rastreamento e uma URL chamada B (incluindo arquivos html e php) necessária para renderizar a página chamada A, mesmo que a URL de B seja bloqueada por robots.txt, o Google pode ser forçado a rastrear para os recursos necessários para a renderização.

Nesses casos, o relatório de cobertura do Search Console mostrará “Bloqueado por robots.txt, mas indexado”.

Não bloqueie os recursos que o Google precisa para renderizar em robots.txt.

Erros de configuração comuns com noindex e robots.txt

Ao contrário do caso acima, se você definir noindex na meta para impedir que os mecanismos de pesquisa exibam uma página indexada existente e também bloquear o rastreamento para essa página em robots.txt, a pesquisa continuará Parece que permanecerá exibida no resultado .

As configurações de robots.txt e configurações de noindex geralmente são mal compreendidas, portanto, é necessário um entendimento correto.

A configuração incorreta do robots.txt é fatal

Se você acidentalmente bloquear todo o seu site logo após ele entrar no ar e antes que o Google o rastreie, muitas páginas não aparecerão nos resultados de pesquisa.

Certifique-se de que não haja descrições incorretas e certifique-se de verificar com o testador do robots.txt.

JavaScript não deve ser bloqueado

Se você se preocupa apenas com a eficiência da patrulha do rastreador, você vai querer bloquear tudo o que você acha que não precisa, mas tome cuidado para não bloquear css ou javascript.

Em 23 de maio de 2014, ele anunciou no blog oficial para webmasters que o poder de processamento do JavaScript do Google havia melhorado. O Google processa páginas da Web como um usuário normal para determinar o conteúdo.

Entendendo melhor as páginas da web

Os links em JavaScript também são avaliados?

De acordo com o Twitter de John Mueller, os links JavaScript passam pelo PageRank como qualquer outro link.

Proibição de clicar com o botão direito e seleção de conteúdo é ruim para SEO?

Do ponto de vista do usuário, desabilitar o clique com o botão direito e a seleção de conteúdo é uma página difícil de usar, mas de acordo com os comentários de John Mueller, isso não parece afetar o SEO.

Não use robots.txt para conteúdo duplicado

Mesmo John Mueller, do Google, não recomenda configurar o robots.txt para evitar conteúdo duplicado.

O Google tem um mecanismo para consolidar classificações de conteúdo distribuído devido a conteúdo duplicado.

Se você bloquear usando robots.txt, também descartará a classificação do conteúdo duplicado bloqueado, portanto, a classificação poderá ser diluída.

Em vez de usar robots.txt, redirecionamentos 301 e atributos canônicos são o caminho correto a seguir.

O que acontece se você bloquear seu próprio robots.txt com robots.txt?

Em particular, não parece afetar como o robots.txt é tratado pelo Google. processado normalmente.

Se o seu robots.txt estiver vinculado a um site externo e for indexado por acaso, o robots.txt não será indexado e não aparecerá nos resultados da pesquisa. (Ele não precisa ser indexado em primeiro lugar.)

Robots.txt basicamente não é indexado, mas se houver um link para esse arquivo de fora e o conteúdo for descrito, parece que foi indexado. Nesses casos, se quiser remover o arquivo robots.txt do índice, você pode usar a ferramenta de remoção de URL ou especificar noindex com o cabeçalho HTTP X-Robots-Tag. (Mas acho que você pode deixá-lo sozinho.)

Ferramenta de remoção de URL

Essa ferramenta permite que você oculte os URLs de seus próprios sites no Search Console dos resultados da pesquisa por 90 dias. Após um determinado período de tempo, ele será exibido novamente nos resultados da pesquisa.

Ocultar um URL com esta ferramenta não bloqueia o rastreamento ou indexação do Google.

Se robots.txt, canonical, noindex etc. forem definidos incorretamente, eles afetarão a exibição e a classificação nos resultados da pesquisa.

O recurso Site SEO Inspection do SE Ranking rastreia as páginas do seu site e detecta automaticamente problemas de SEO, incluindo configurações do robots.txt.

Você pode verificar os itens que afetam ” Rastreamento ” e ” Índice ” pelo seguinte método .

Leave a Reply